Достижения в области компьютерного зрения и машинного обучения позволили широкому спектру технологий выполнять сложные задачи практически без участия человека. От автономных дронов и беспилотных автомобилей до медицинской визуализации и производства продуктов — многие компьютерные приложения и роботы используют визуальную информацию для принятия важных решений. Города все больше полагаются на эти автоматизированные технологии для общественной безопасности и обслуживания инфраструктуры.

Однако, по сравнению с людьми, компьютеры видят своего рода туннельное зрение, что делает их уязвимыми для атак с потенциально катастрофическими последствиями. Например, водитель-человек, увидев граффити на знаке «Стоп», все равно узнает его и остановит машину на перекрестке. С другой стороны, граффити может привести к тому, что беспилотный автомобиль пропустит знак остановки и проедет через перекресток. И в то время как человеческий разум может отфильтровывать все виды необычной или посторонней визуальной информации при принятии решения, компьютеры зацикливаются на крошечных отклонениях от ожидаемых данных.

Это связано с тем, что мозг бесконечно сложен и может одновременно обрабатывать множество данных и прошлого опыта, чтобы принимать почти мгновенные решения, соответствующие ситуации. Компьютеры полагаются на математические алгоритмы, обученные на наборах данных. Их творчество и познание ограничены пределами технологий, математики и человеческого предвидения.

Злоумышленники могут воспользоваться этой уязвимостью, изменив то, как компьютер видит объект, либо изменив сам объект, либо какой-либо аспект программного обеспечения, связанного с технологией машинного зрения. Другие атаки могут манипулировать решениями, которые компьютер принимает в отношении того, что он видит. Любой подход может означать бедствие для отдельных лиц, городов или компаний.

Группа исследователей из Инженерного колледжа Борнса Калифорнийского университета в Риверсайде работает над способами предотвращения атак на системы компьютерного зрения. Для этого Салман Асиф, Шрикант Кришнамурти, Амит Рой-Чоудхури и Ченгюй Сонг сначала выясняют, какие атаки работают.

«Люди хотели бы проводить эти атаки, потому что есть много мест, где машины интерпретируют данные для принятия решений», — сказал Рой-Чоудхури, главный исследователь недавно завершившейся программы DARPA AI Explorations под названием «Методы нарушения машинного зрения». «В интересах злоумышленника может быть манипулирование данными, на основе которых машина принимает решение. Как злоумышленник атакует поток данных, чтобы решения были неверными?»

Злоумышленник может внедрить какое-нибудь вредоносное ПО в программное обеспечение беспилотного автомобиля, например, чтобы данные, поступающие с камеры, слегка искажались. В результате модели, установленные для распознавания пешехода, дают сбой, и система будет галлюцинировать объект или не видеть существующий объект. Понимание того, как создавать эффективные атаки, помогает исследователям разрабатывать более эффективные механизмы защиты.

«Мы думаем, как исказить изображение, чтобы при его анализе системой машинного обучения оно было неправильно классифицировано», — сказал Рой-Чоудхури. «Есть два основных способа сделать это: дипфейки, когда лицо или выражение лица кого-то в видео были изменены, чтобы обмануть человека, и состязательные атаки , в которых злоумышленник манипулирует тем, как машина принимает решение, а человек обычно не ошибаются. Идея состоит в том, что вы делаете очень небольшое изменение в изображении, которое человек не может воспринять, но автоматизированная система сделает ошибку».

Рой-Чоудхури, его сотрудники и их ученики обнаружили, что большинство существующих механизмов атаки нацелены на неправильную классификацию определенных объектов и действий. Однако большинство сцен содержат несколько объектов, и обычно между объектами в сцене существует некоторая взаимосвязь, то есть одни объекты встречаются чаще, чем другие.

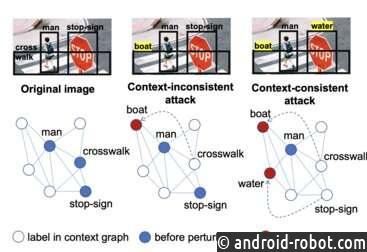

Люди, изучающие компьютерное зрение , называют это совпадение «контекстом». Члены группы показали, как разрабатывать контекстно-зависимые атаки, которые изменяют отношения между объектами в сцене.

«Например, стол и стул часто можно увидеть вместе. Но тигра и стула редко можно увидеть вместе. Мы хотим манипулировать ими всеми вместе», — сказал Рой-Чоудхури. «Вы можете изменить знак «Стоп» на знак ограничения скорости и убрать пешеходный переход. Если вы замените знак «Стоп» на знак ограничения скорости, но оставите пешеходный переход, компьютер в беспилотном автомобиле все равно может распознать ситуацию, когда нужно остановиться».

Ранее в этом году на конференции Ассоциации развития искусственного интеллекта исследователи показали, что для того, чтобы машина приняла неправильное решение, недостаточно манипулировать только одним объектом. Группа разработала стратегию создания состязательных атак, которые последовательно изменяют несколько объектов одновременно.

«Наше основное понимание заключалось в том, что успешные атаки передачи требуют целостного манипулирования сценой. Мы изучаем граф контекста, чтобы направлять наш алгоритм, на какие объекты следует нацеливаться, чтобы обмануть модель жертвы, сохраняя при этом общий контекст сцены», — сказал Салман Асиф.

В документе, представленном на этой неделе на конференции Conference on Computer Vision and Pattern Recognition, исследователи вместе со своими сотрудниками из PARC, исследовательского подразделения компании Xerox, развивают эту концепцию и предлагают метод, к которому у злоумышленника не было доступа. к компьютерной системе жертвы. Это важно, потому что при каждом вторжении злоумышленник рискует быть обнаруженным жертвой и получить защиту от атаки. Таким образом, наиболее успешными атаками, скорее всего, будут те, которые вообще не исследуют систему жертвы, и очень важно предвидеть и разработать защиту от таких атак с нулевым запросом.

В прошлом году та же группа исследователей использовала контекстуальные связи во времени для организации атак на видеоряды. Они использовали геометрические преобразования для разработки очень эффективных атак на системы классификации видео. Алгоритм приводит к успешным возмущениям за удивительно малое число попыток. Например, вредоносные примеры, сгенерированные с помощью этой техники, имеют более высокие показатели успешности атак с меньшим количеством попыток на 73% по сравнению с современными методами для видео-состязательных атак. Это позволяет проводить более быстрые атаки с гораздо меньшим количеством попыток проникновения в систему жертвы. Этот документ был представлен на главной конференции по машинному обучению Neural Information Processing Systems 2021.

Тот факт, что контекстно-зависимые состязательные атаки гораздо более эффективны на естественных изображениях с несколькими объектами, чем существующие атаки, которые в основном сосредоточены на изображениях с одним доминирующим объектом, открывает путь к более эффективной защите. Эти средства защиты могут учитывать контекстуальные отношения между объектами на изображении или даже между объектами в сцене на изображениях с нескольких камер. Это открывает потенциал для разработки значительно более безопасных систем в будущем.