В последние годы ученые-компьютерщики пытаются создавать все более совершенные диалоговые и информационные системы. Выпуск ChatGPT и других высокопроизводительных языковых моделей демонстрирует, насколько далеко может зайти искусственный интеллект в ответах на вопросы пользователей, написании текстов и общении с людьми.

Исследователи из Калифорнийского университета в Риверсайде, École Normale Supérieure (ECN) в Париже и Ludwig-Maximilians-Universität München разработали большую языковую модель, которая может отвечать на философские вопросы голосом конкретного философа. Эта модель, представленная в статье, опубликованной на сервере препринтов arXiv , может автономно генерировать ответы, очень похожие на ответы, полученные философами-людьми.

«Анна Штрассер, Мэтью Кросби и я заметили, что люди создают результаты GPT-3 в стиле различных писателей или других философов», — сказал Tech Xplore Эрик Швитцгебель, один из исследователей, проводивших исследование. «Мы подумали, что было бы интересно посмотреть, сможем ли мы точно настроить GPT-3 (Generative Pre-trained Transformer 3) на основной части работы философа, а затем задать ему вопросы и посмотреть, говорит ли он то, что мог бы сказать настоящий философ.»

Исследователи решили использовать GPT-3, модель, созданную OpenAI, которая лежит в основе функционирования ChatGPT. Сначала эту модель обучали на текстах Канта, затем на блоге Швицгебеля под названием The Spintered Mind и, наконец, с его разрешения на большинстве работ американского философа Дэниела Деннета.

«Мы решили, что было бы интересно посмотреть, смогут ли эксперты отличить доработанную модель от ответов Деннета на те же вопросы», — сказал Швицгебель. «Мэтту пришлось покинуть проект, поэтому мы взяли на борт моего сына Дэвида Швитцгебеля, который учится в аспирантуре ENS в Париже».

GPT-3 — это авторегрессивная языковая модель, которая использует глубокое обучение для генерации текстов. Модель по существу предсказывает следующее слово в предложении или последовательности слов, используя сложные и мощные статистические методы.

«Например, предположим, я говорю: «Я собираюсь взять свою жену в романтическое путешествие в», а затем прошу вас угадать следующее слово», — объяснил Швицгебель. «Предположительно, вы с большей вероятностью ответите «Париж», чем «мусор» или «желтый», хотя, конечно, предложение можно закончить по-разному. Используя огромный корпус текста, GPT-3 исследует весь предшествующий контекст. предложения (до нескольких сотен слов), а затем статистически угадывает следующее слово. Он делает это не потому, что «знает», что Париж романтичен, а скорее потому, что в большой базе данных об использовании языка он встречал такие слова, как «романтический ‘ и «поездка» предшествует «Париж» чаще, чем предшествует «мусор».

В рамках своего недавнего исследования Швицгебель и его коллеги настроили GPT-3 на основе прошлых работ Даннета. Другими словами, они дополнительно обучили модель на текстах философа, чтобы убедиться, что она взвешивает типичные шаблоны словоупотребления Деннета более сильно, чем другие шаблоны словоупотребления, при прогнозировании следующего слова в предложении.

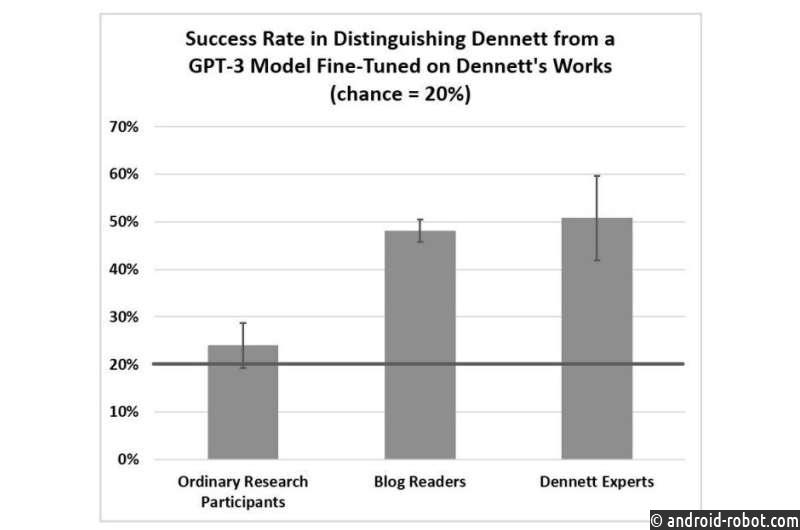

«Меня особенно поразило, что эксперты смогли правильно угадать только в 50% случаев, учитывая ответы Деннета и четыре неверных результата GPT-3, что лучше, чем вероятность 20%, но и близко не соответствует нашей гипотезе. ставка 80%», — сказал Швицгебель. «Отбор вишни означает, что мы не пытались выбрать хорошие результаты. Мы просто взяли первые результаты, которые соответствовали нескольким механическим критериям. Это говорит о том, что точно настроенная модель GPT-3 может быть удивительно близка к разговору голос конкретного философа».

Чтобы оценить свою модель, которую они назвали «Digi-Dan», исследователи опросили 425 пользователей-людей, могут ли они отличить ответы на философские вопросы, сгенерированные моделью, от ответов, полученных Деннетом. Примечательно, что они обнаружили, что опытные философы и читатели философских блогов могли распознать ответы философа примерно в 50% случаев, в то время как обычные участники, не знающие философии или совсем не знакомые с философией, узнавали ответы Деннета примерно в 20% случаев.

Эти результаты показывают, что тексты, созданные «DigiDan», иногда могут быть ошибочно приняты за тексты, написанные философом, но все же есть возможности для улучшения. В будущем Швицгебель и его коллеги планируют продолжить работу над своей моделью и изучить ее возможные реализации в реальных условиях.

«Сейчас мы начинаем думать о возможных социальных последствиях этого и его потенциале в качестве инструмента», — добавил Швицгебель. «Например, мог ли философ доработать модель своей собственной работы, а затем использовать ее результаты в качестве источника идей? Мог ли историк философии создать модель философа, а затем задать ей вопросы, которые никогда не задавали философу- историку? «На тот момент мы не могли полагаться на то, что результаты будут надежными, но они могли, по крайней мере, наводить на размышления и наводить на размышления».