Поскольку использование алгоритмов машинного обучения (ML) продолжает расти, специалисты по информатике во всем мире постоянно пытаются определить и устранить способы, которыми эти алгоритмы могут использоваться злонамеренно или ненадлежащим образом. Фактически, благодаря своим расширенным возможностям анализа данных, подходы ML могут позволить третьим сторонам получать доступ к личным данным или быстро и эффективно проводить кибератаки.

Мортеза Варасте, исследователь из Университета Эссекса в Великобритании, недавно определил новый тип атаки на вывод, которая потенциально может скомпрометировать конфиденциальные пользовательские данные и передать их другим сторонам. Эта атака, подробно описанная в статье, предварительно опубликованной на arXiv , использует вертикальное федеративное обучение (VFL) — сценарий распределенного машинного обучения, в котором две разные стороны обладают разной информацией об одних и тех же лицах (клиентах).

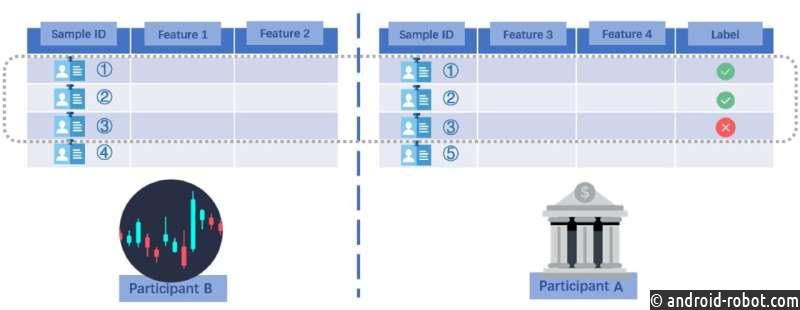

«Эта работа основана на моем предыдущем сотрудничестве с коллегой из Nokia Bell Labs, где мы представили подход к извлечению частной информации о пользователе в центре обработки данных, называемом пассивной стороной (например, страховой компанией)», — сказал Варасте Tech . Исследуйте. «Пассивная сторона сотрудничает с другим центром обработки данных , называемым активной стороной (например, банком), для создания алгоритма машинного обучения (например, алгоритма одобрения кредита для банка)».

Основная цель недавнего исследования Varasteh состояла в том, чтобы показать, что после разработки модели машинного обучения в условиях вертикального федеративного обучения (VFL) так называемая «активная сторона» потенциально может извлекать конфиденциальную информацию пользователей, которая предоставляется только другая сторона, участвующая в построении модели ML. Активная сторона может сделать это, используя собственные доступные данные в сочетании с другой информацией о модели ML.

Важно отметить, что это можно было сделать без запроса о пользователе с другой стороны. Это означает, что, например, если банк и страховая компания совместно разработают алгоритм ML, банк может использовать эту модель для получения информации о своих собственных клиентах, которые также являются клиентами страховой компании, без получения их разрешения.

«Рассмотрите сценарий, в котором банк и страховая компания имеют много общих клиентов, причем клиенты делятся некоторой информацией с банком, а частично со страховой компанией», — пояснил Варастех. «Чтобы создать более мощную модель одобрения кредита, банк сотрудничает со страховой компанией в создании алгоритма машинного обучения (ML). Модель построена, и банк использует ее для обработки кредитных заявок, в том числе от клиента по имени Алекс. , который также является клиентом страховой компании».

В сценарии, описанном Varasteh, банк может быть заинтересован в том, чтобы узнать, какой информацией Алекс (гипотетический пользователь, которым они делятся со страховой компанией) поделился со страховой компанией. Разумеется, эта информация является частной, поэтому страховая компания не может свободно делиться ею с банком.

«Чтобы преодолеть это, банк может создать еще одну модель машинного обучения на основе собственных данных, чтобы имитировать модель машинного обучения, созданную совместно со страховой компанией», — сказал Варастех. «Автономная модель машинного обучения оценивает общую ситуацию Алекса в страховой компании, принимая во внимание данные, которыми Алекс поделился с банком. может использовать набор уравнений, чтобы найти личную информацию Алекса, доступную только страховой компании».

Атака логического вывода, описанная Варастехом в его статье, применима ко всем сценариям, в которых две стороны (например, банки, компании, организации и т. д.) совместно используют некоторых общих пользователей и владеют конфиденциальными данными этих пользователей. Выполнение этих типов атак потребует от «активной» стороны найма разработчиков для создания автономных моделей машинного обучения — задача, которую теперь становится легче выполнить.

«Мы показываем, что банк (то есть активная сторона) может использовать имеющиеся у него данные для оценки результатов модели VFL, созданной совместно со страховой компанией», — сказал Варастех.

«Как только эта оценка получена, можно решить набор математических уравнений, используя параметры модели VFL, чтобы получить личную информацию гипотетического пользователя Алекса. Стоит отметить, что личная информация Алекса не должна быть никому известна. Хотя в документе дополнительно были представлены некоторые контрмеры для предотвращения этого типа атаки, сама атака по-прежнему является заметной частью результатов исследования».

Работа Варасте проливает новый свет на возможное злонамеренное использование моделей машинного обучения для незаконного доступа к личной информации пользователей. Примечательно, что описанный им сценарий атаки и утечки данных не рассматривался в предыдущей литературе.

В своей статье исследователь из Университета Эссекса предлагает схемы сохранения конфиденциальности (PPS), которые могут защитить пользователей от такого типа атак логического вывода. Эти схемы предназначены для искажения параметров модели VFL, которые соответствуют характеристикам данных, хранящихся у так называемой пассивной стороны, такой как страховая компания в сценарии, описанном Varasteh. В той или иной степени искажая эти параметры, пассивные стороны, совместно помогающие активной стороне построить модель машинного обучения, могут снизить риск того, что активная сторона получит доступ к конфиденциальным данным своих клиентов.

Эта недавняя работа может вдохновить других исследователей на оценку рисков недавно обнаруженной атаки логического вывода и выявление подобных атак в будущем. Между тем, Varasteh намеревается дополнительно изучить структуры VFL, выискивая потенциальные лазейки в конфиденциальности и разрабатывая алгоритмы, которые могли бы закрыть их с минимальным ущербом для всех вовлеченных сторон.

«Основная цель VFL — позволить создавать мощные модели машинного обучения, обеспечивая при этом сохранение конфиденциальности пользователей», — добавил Варастех. «Однако в VFL существует тонкая дихотомия между пассивной стороной, которая отвечает за безопасность пользовательской информации, и активной стороной, которая стремится лучше понять модель VFL и ее результаты. Предоставление разъяснений по результатам модели . по своей сути может привести к способам извлечения частной информации. Поэтому предстоит еще много работы с обеих сторон и для различных сценариев в контексте VFL».