Свобода слова против вредоносной дезинформации: как люди решают дилеммы модерации онлайн-контента.

Модерация онлайн-контента — это моральное минное поле, особенно когда свобода выражения мнений вступает в противоречие с предотвращением вреда, причиняемого дезинформацией. В исследовании, проведенном группой исследователей из Института человеческого развития Макса Планка, Эксетерского университета, Амстердамского свободного университета и Бристольского университета, изучалось, как общественность будет справляться с такими моральными дилеммами.

Они обнаружили, что большинство респондентов примут меры для контроля за распространением дезинформации , в частности, если она будет вредной и будет распространяться неоднократно. Результаты исследования могут быть использованы для информирования о согласованных и прозрачных правилах модерации контента, которые широкая общественность считает законными.

Проблема модерации контента в социальных сетях стала предметом пристального внимания в 2021 году, когда основные платформы, такие как Facebook и Twitter, заблокировали учетные записи тогдашнего президента США Дональда Трампа. Дебаты продолжались, поскольку платформы столкнулись с опасной дезинформацией о COVID-19 и вакцинах, а также после того, как Илон Маск единолично отменил политику Twitter в отношении дезинформации о COVID-19 и восстановил ранее заблокированные учетные записи.

«До сих пор платформы социальных сетей принимали ключевые решения по модерированию дезинформации, что фактически ставит их в положение арбитров свободы слова . — говорит ведущий автор исследования Анастасия Козырева, научный сотрудник Института развития человека им. Макса Планка.

«Чтобы адекватно справляться с конфликтами между свободой слова и вредоносной дезинформацией, нам нужно знать, как люди справляются с различными формами моральных дилемм при принятии решений о модерации контента», — добавляет Ральф Хертвиг, директор Центра адаптивной рациональности Института Макса Планка. Развитие человека.

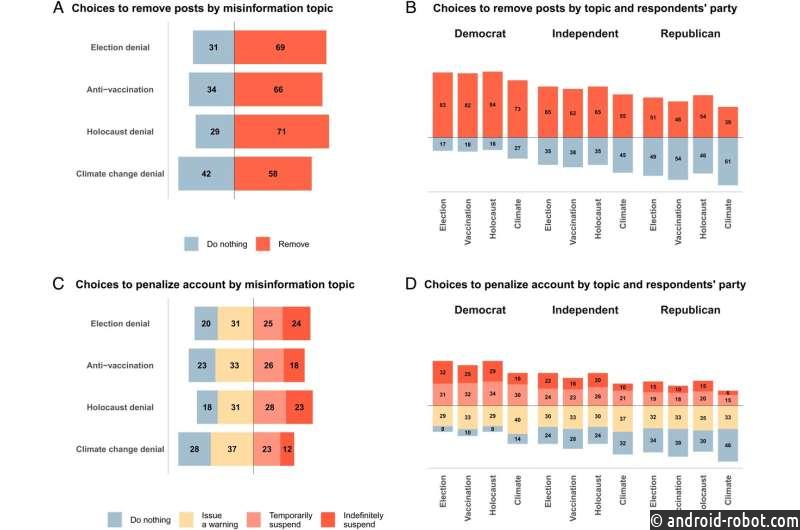

В ходе эксперимента по совместному опросу более 2500 респондентов из США указали, будут ли они удалять сообщения в социальных сетях , распространяющие дезинформацию о демократических выборах, прививках, Холокосте и изменении климата. Их также спросили, примут ли они карательные меры в отношении учетных записей путем вынесения предупреждения или временной или бессрочной приостановки. Респондентам была показана информация о гипотетических аккаунтах, включая политическую направленность и количество подписчиков, а также посты аккаунтов и последствия содержащейся в них дезинформации.

Большинство респондентов предпочли предпринять какие-либо действия для предотвращения распространения вредоносной дезинформации. В среднем 66% респондентов заявили, что удалят оскорбительные посты, а 78% предпримут какие-либо действия в отношении аккаунта (из которых 33% решили «вынести предупреждение», а 45% решили на неопределенный срок или временно приостановить действие аккаунтов, распространяющих дезинформацию). . Не вся дезинформация подвергалась одинаковому наказанию: меньше всего реагировали на отрицание изменения климата (58%), в то время как на отрицание Холокоста (71%) и отрицание выборов (69%) реагировали чаще всего, за ними следовал контент против вакцинации (66%). ).

«Наши результаты показывают, что так называемые абсолютисты свободы слова, такие как Илон Маск, оторваны от общественного мнения. Люди в целом признают, что должны быть ограничения свободы слова, а именно, когда она может причинить вред, и что удаление контента или даже деплатформирование может быть уместно в экстремальных обстоятельствах, таких как отрицание Холокоста», — говорит соавтор Стефан Левандовски, заведующий кафедрой когнитивной психологии Бристольского университета.

Исследование также проливает свет на факторы, влияющие на решения людей относительно модерации контента в Интернете. Тема, тяжесть последствий дезинформации и то, было ли это повторным нарушением, оказали самое сильное влияние на решения об удалении постов и блокировке аккаунтов. Характеристики самой учетной записи — человек, стоящий за учетной записью, его приверженность и количество подписчиков — практически не влияли на решения респондентов.

Респонденты не были более склонны удалять сообщения из аккаунта с противоположной политической позицией, и при этом они не были более склонны блокировать аккаунты, которые не соответствовали их политическим предпочтениям. Однако республиканцы и демократы, как правило, использовали разные подходы к решению дилеммы между защитой свободы слова и удалением потенциально вредной дезинформации. Демократы предпочитали предотвращать опасную дезинформацию во всех четырех сценариях, тогда как республиканцы предпочитали защищать свободу слова, вводя меньше ограничений.

«Мы надеемся, что наше исследование поможет разработать прозрачные правила модерации контента в отношении вредоносной дезинформации. Предпочтения людей — не единственный критерий для принятия важных компромиссов при модерации контента, но игнорирование того факта, что существует поддержка для принятия мер против дезинформации и учетные записи, которые публикуют его, рискуют подорвать доверие общественности к политике и правилам модерации контента», — говорит соавтор, профессор Джейсон Рейфлер из Эксетерского университета.

«Эффективное и осмысленное регулирование платформы требует не только четких и прозрачных правил модерации контента, но и всеобщего признания правил в качестве законных ограничений основного права на свободное выражение мнения. Это важное исследование имеет большое значение для информирования политиков о том, что есть и, что еще более важно, что является неприемлемым пользовательским контентом», — добавляет соавтор, профессор Марк Лейзер из Амстердамского свободного университета.