Стремительный прогресс в области искусственного интеллекта (ИИ) вызывает серьезную этическую озабоченность. Для многих сотрудников, которые не заметили значительного роста заработной платы в течение десятилетий, искусственный интеллект представляет потенциальную угрозу для рабочих мест, от которых они зависят, и его потенциальное взаимодействие с последствиями глобализации вызывает тревогу. Вдумчивые наблюдатели беспокоятся о его способности усилить концентрацию государственной и частной власти, увеличить информационную асимметрию и уменьшить прозрачность—все это за счет граждан. В этих условиях под сомнение ставится значение индивидуального согласия и свобод граждан—одного из признаков свободного демократического общества.

Разработчики искусственного интеллекта в частном секторе знают об этих проблемах, и они приступили к разработке кодексов, регулирующих их собственную деятельность. Например, Корпорация Майкрософт изложила шесть принципов создания систем ИИ: справедливость, безопасность и надежность, конфиденциальность, включение, прозрачность и подотчетность. Каждый из этих принципов, в свою очередь, необходимо будет уточнить и применить к целому ряду случаев. Компания Google сделала то же самое через своих разработчиков искусственного интеллекта. Многие другие компании рассматривают и разрабатывают этические кодексы, чтобы применять их в корпоративных решениях.

Принципы использования Искусственного Интеллекта

Но применять эти принципы к искусственному интеллекту — дело не простое. Возьмем в качестве примера справедливость. Это потребует систематических усилий для обеспечения того, чтобы данные, из которых программы ИИ могут “учиться”, были репрезентативными для соответствующего населения. Для этого также потребуется способность проводить различие между решениями, основанными на алгоритмах, на статистических закономерностях, и индивидуальными определениями. Местные банкиры часто принимают решения о выдаче кредитов и займов, опираясь на свои знания о характере отдельных заемщиков, многие из которых могут не претендовать на получение кредитов, если им придется соблюдать стандарты региональных и национальных финансовых учреждений.

Некоторые виды принципа справедливости не могут быть сведены к Правилам. Как показывает пример банковского кредитования, универсальное применение вероятностных обобщений может создать свою собственную несправедливость, когда они исключают лиц, которые не могут соответствовать стандартам эффективности программы искусственного интеллекта. Об этом пишет сетевое издание Новости Технологий.

Другие принципы порождают различные проблемы. Что означает прозрачность применительно к автономным системам искусственного интеллекта, создатели которых не могут предсказать, что эти системы будут делать, когда они загрузят новые данные, включая обратную связь с предыдущими выводами? Что означает конфиденциальность, когда эти системы могут не только отслеживать отдельных лиц, но и побуждать (или, как говорят поведенческие экономисты, подтолкнуть) к новым действиям, основанные на статистических выводах из их прошлого поведения?

Помимо этих неизбежных вопросов, существуют еще более острые вопросы, требующие рассмотрения.

Как далеко может зайти саморегулирование систем искусственного интеллекта в частном секторе?

При каких обстоятельствах государственный сектор должен вмешиваться в сферу частных разработок ИИ?

И когда это происходит, каковы соответствующие этические принципы?

В этой аналитической записке будут рассмотрены эти вопросы с использованием трех тематических исследований: системы распознавания лиц, самоходные (беспилотные) транспортные средства и смертоносное автономное оружие. Я использую эти примеры, чтобы проиллюстрировать этические проблемы ИИ и необходимость прояснить наше мышление в этой области.

Распознавание лиц Искусственным Интеллектом

В 1791 году британский философ и социальный реформатор Джереми Бентам опубликовал предложение о новой тюрьме под названием «Паноптикон», призванной позволить одному охраннику наблюдать за всеми заключенными, не будучи видимым для них. Идея считалась причудливой, и Бентам умер озлобленным, так как правительство не поддержало его идею. Но это стало мощным символом для антиутопической перспективы всеобщего наблюдения.

Сегодня, с развитием компьютерного распознавания лиц с помощью применения технологии искусственного интеллекта, перспектива наблюдения за людьми стала слишком реальной. Китайское правительство имеет возможность отслеживать перемещения многих жителей, находящихся под его юрисдикцией. Для обществ, которые ценят свободу и частную жизнь, этот новый потенциал вызывает глубокие этические проблемы—для экспертов, которые его создают, для предприятий, которые продают эту технологию, и для правительств, которые должны решить, как использовать технологию распознавания лиц искусственным интеллектом и как её регулировать.

В июле этого года Брэд Смит, президент Microsoft, ответил срочным призывом. С одной стороны, он сообщил, что некоторые новые виды использования технологий ИИ по распознаванию лиц являются положительными: представьте, что полиция может найти похищенного ребенка, узнав ребенка по лицу с помощью ИИ, и найти похитителей. Также с помощью технологии можно выделить террориста из толпы на спортивном мероприятии. Но другие потенциальные приложения пугают, добавляет он: «представьте, что правительство (либо крупные корпорации) отслеживает вас повсюду . . . без вашего разрешения или ведома. Представьте себе базу данных всех, кто присутствовал на политическом митинге. Это и есть свобода, и такого не должно быть в демократическом обществе.”

«Распознавание лиц вызывает критический вопрос», — настаивает он: «какую роль мы хотим, чтобы этот тип технологий играл в повседневном обществе? Критики слежки за людьми иногда ссылаются на норму, » разумное ожидание конфиденциальности.»Но идея конфиденциальности не согласуется по своей природе с наблюдением деятельности граждан в таких пространствах, как общественные улицы. И люди, которые ищут и получают выгоду от рекламы, вряд ли могут пожаловаться, если их признают в общественных местах.

Более подходящей нормой, я предлагаю, является разумное ожидание анонимности. Если мы занимаемся нашим бизнесом на законном основании, государственные органы не должны использовать системы распознавания лиц для идентификации и отслеживания нас без достаточно весомого обоснования, так как существует презумпция невиновности. Идентификация конкретных лиц должна требовать эквивалента ордера на обыск, который для большинства целей разрешен только по вероятной причине — совершения преступления. Одного подозрения недостаточно.

Идентификация конкретных лиц должна требовать эквивалента ордера на обыск, который для большинства целей разрешен только по вероятной причине — совершения преступления. Одного подозрения недостаточно.

Если преступление было совершено, презумпция смещается в сторону глобального поиска преступников. Системы распознавания лиц могут быть использованы, например, для идентификации лиц, покидающих место ограбления банка. Некоторые могут оказаться невинными жертвами, опасаясь за свою жизнь; другие могут быть преступниками.

Эти вопросы были бы актуальными, даже если бы технология распознавания лиц искусственным интеллектом была совершенной, но это далеко не так. Последние исследования показывают, что в настоящее время технология распознавания лиц работает лучше с мужчинами, чем для женщинами и людьми с более светлым цветом лица, чем для людей со смуглой кожей лица. Нельзя игнорировать опасность ложных срабатываний тревоги при распознании лиц ИИ.

В настоящее время технология распознавания лиц работает лучше для мужчин, чем для женщин и людей с более светлым цветом кожи лица, чем для людей с цветом.

Этот риск имеет значение, потому что большинство из нас склонны придавать большое значение технологическим инновациям.

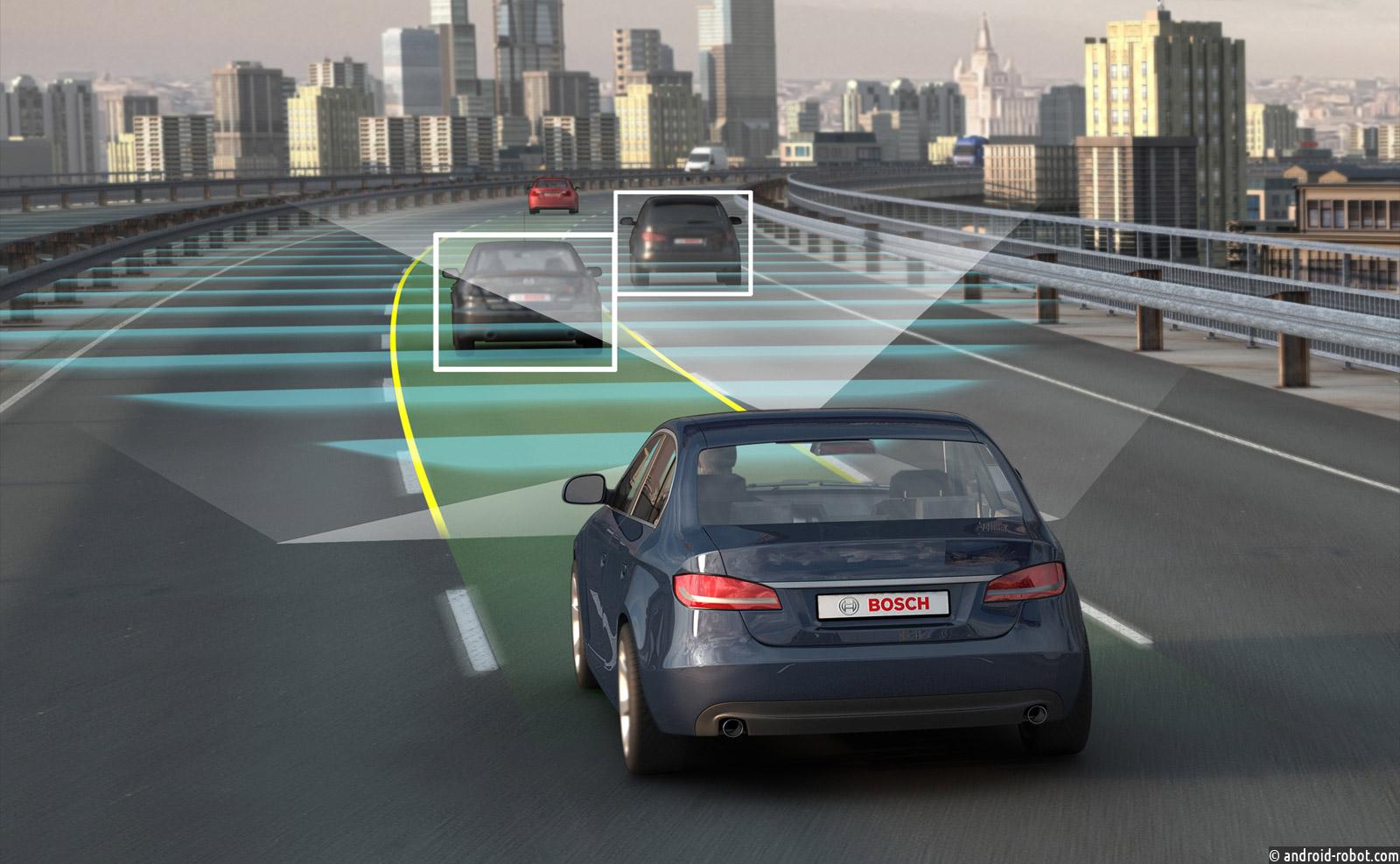

Автономные (беспилотные) транспортные средства

Вы едете на предельной скорости по двухполосной пригородной дороге, когда мяч катится в сторону дороги и за ним бежит ребенок. На другой полосе есть встречная машина, и времени на остановку, чтобы не сбить ребенка не хватает. Что сделаете вы?

Если вы нормальный и адекватный человек, вы сделать все возможное, чтобы избежать аварии с участием ребенка, но не ценой собственной жизни. Ваши варианты включают в себя: сворачивание влево через полосу, идущую в противоположном направлении, сводя к минимуму вероятность столкновения с ребенком, но на риск дтп со встречным автомобилем; или сворачивание вправо, увеличивая шансы на столкновение автомобиля с ребенком.

Эта оценка ситуации предполагает, что встречный автомобиль будет оставаться в своей полосе при торможении. Но было бы разумно, чтобы водитель встречного автомобиля увидел, что ребенок может продолжать бежать через дорогу. Чтобы минимизировать риск для ребенка, этот водитель поворачивает вправо, уменьшая шансы на столкновение, если другой водитель поворачивает влево. Оптимальная стратегия зависит от взаимодействия между водителями.

Теперь немного измените пример: предположим, что вы являетесь родителем ребенка, который бежит на дорогу за мячом. В этом случае вы можете рискнуть пожертвовать собственной жизнью, чтобы спасти своего ребенка. Если это так, то оптимальной стратегией является резко свернуть влево, независимо от риска столкновения со встречным автомобилем.

Еще раз измените пример: вы едете с ребенком, пристегнутым к автокреслу в задней части вашего автомобиля, когда ребенок, которого Вы не знаете, бежит на улицу. Вам морально необходимо быть нейтральным между жизнью вашего ребенка и жизни незнакомого ребенка? Если нет, то оптимальной стратегией является правильный поворот.

Еще один пример: вы едете с ребенком, когда двое других детей бегут на улицу. Влияют ли количество детей на моральное суждение?

Эти примеры были приведены для того, чтобы подчеркнуть те проблемы, с которыми сталкиваются конструкторы автономных транспортных средств.

Во-первых, поскольку взаимодействие между транспортными средствами имеет значение, либо правительство, либо промышленный консорциум должны разработать протокол между моделями и производителями, который будет регулировать взаимодействие в максимально широком диапазоне случаев. Одной из возможностей является система датчиков и передатчиков в каждом транспортном средстве, которая мгновенно передает сигналы при проблемных ситуациях и позволяет координировать движение в режиме реального времени между транспортными средствами.

Во-вторых, программные решения должны соответствовать этическим соображениям. Эти ответы должны быть явными и четко определенными. И сами автопроизводители не имеют права принимать эти решения, которые должны отражать публичные обсуждения и дебаты.

В-третьих, поскольку особые обстоятельства имеют значение, автономные транспортные средства должны иметь возможность получать и развертывать соответствующую информацию в максимально возможной степени. Система управления транспортного средства считывать эмоциональное и другие состояния пользователя. Для этого может потребоваться установка датчиков и даже устройств распознавания лиц в качестве элементов автономного водительского пакета.

Наконец, размещение автономных транспортных средств приведет к смещению баланса ответственности перед их производителями. Лица не могут нести ответственность за дефекты программирования-или решения, — которые они не имеют возможности диагностировать. Как утверждал Брайант Уокер Смит, существующий свод закона об ответственности за продукт может быть легко скорректирован, чтобы учесть проблемы автономных транспортных средств. Это необходимо сделать до того, как эти транспортные средства будут общедоступны, как часть процесса регулирования, регулирующего их внедрение. Было бы обременительно и несправедливо заставлять отдельных истцов обращаться в суд для установления стандартов, которые правительство обязано установить заранее.

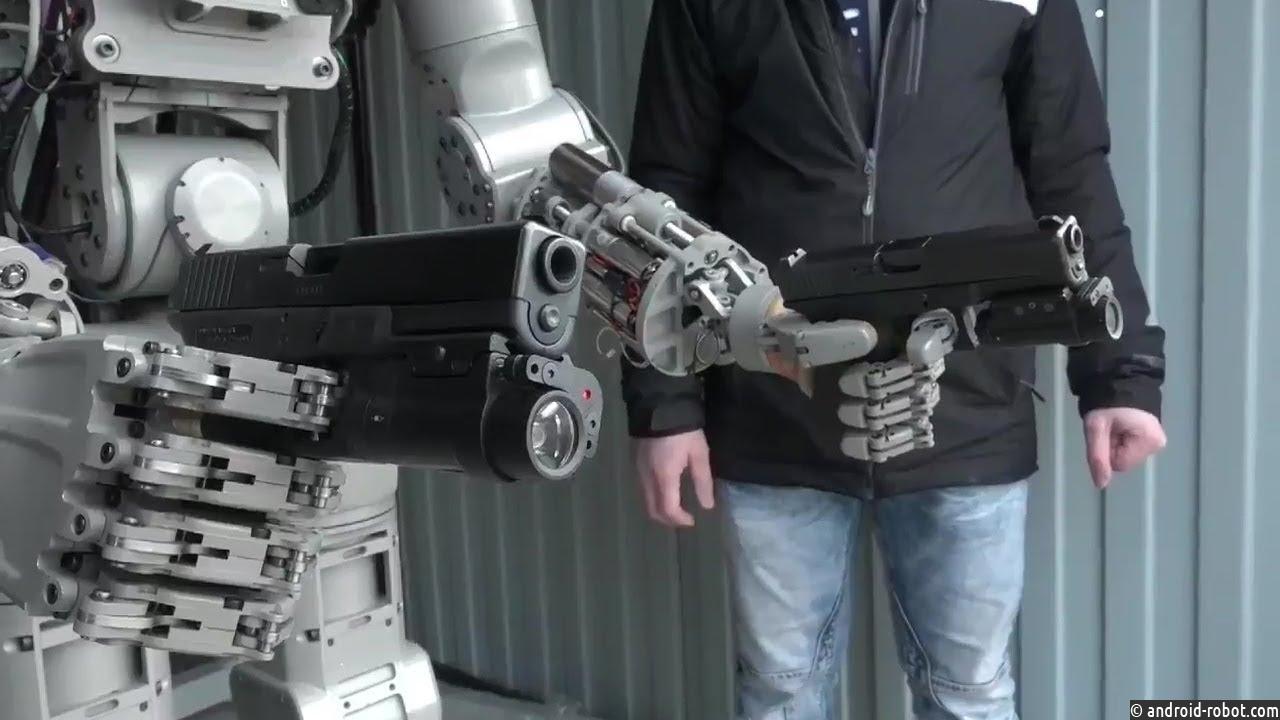

Военные роботы. Оружие с искусственным интеллектом

Как уже давно известно, решение лишить других людей жизни поднимает самые серьезные этические вопросы и требует самой большой степени осторожности. Когда люди взаимодействуют с технологией при принятии этих решений, возникают новые проблемы.

Рассмотрим следующий случай. В 1988 году американский ракетный крейсер Vincennes, находящийся в Персидском заливе, сбил иранский пассажирский самолет, в результате чего погибли все 290 человек на борту. Курс, скорость и радиосигнал самолета правильно показали, что это был гражданский самолет. Но система Искусственного интеллекта Aegis корабля, которая была запрограммирована на советские бомбардировщики, неправильно определила ее. Несмотря на данные стандартных индикаторов, ни один из 18 членов экипажа Aegis не был готов бросить вызов компьютеру, и поэтому они разрешили стрелять из ракеты, которая сбила иранский самолет. Результатом стала человеческая трагедия, которая повредила репутацию американских военных и ухудшила без того плохие отношения между правительствами США и Ирана.

Конечно, система Aegis не была полностью автономной. На командире экипажа была главная ответственность за разрешение ситуации. Но этот случай подчеркивает неоправданное предпочтение, которое мы склонны дать технологии, которые мы создаем, даже когда доказательства наших чувств противоречат этому. Инвестирование в технологии, наделенных полномочиями действовать в конкретных случаях без человеческого вмешательства и контроля, лишь усугубит опасность.

Многие существующие процедуры признают этот риск. Например, не только человеческие операторы управляют беспилотниками, но также Белый дом и Министерство обороны создали сложный протокол, чтобы принимать решения о ударах по конкретным целям. Цель должна быть точно определена вне всяких разумных сомнений. Кроме того, необходимо взвесить внутренние законы и нормы—например, тот факт, что Анвар Аль-Авлаки, который повлиял на молодых людей, чтобы стать террористами, был гражданином США. Лица, принимающие решения, должны соотнести факты и обстоятельства каждого дела, чтобы прийти к суждению о вещах и принятии решения.

Существует разница между смертоносным оружием направленным на уничтожение людей, и оружием направленное на уничтожение автономной цели. Но это различие не в полной мере решает этический вопрос, потому что цель должна быть точно определена как беспилотная. Полностью автономный противоракетный комплекс должен определить, что объект является ракетой, а не (скажем) дружественным самолетом. Как показывает эпизод с кораблем ВМФ США Vincennes, способность конкретной технологии должна контролироваться человеком, нельзя полностью доверяться искусственному интеллекту.

Вспомним также, о сбоях систем ядерного вооружения во временя Холодной войны между США и Советским Союзом. С обеих сторон были случая, когда система дала сбой и была команда на запуск баллистических ядерных ракет, но наш Мир спас человеческий фактор. И такие ситуации в мире были не в первый раз.

Широкое утверждение о том, что » машинное программирование никогда не достигнет точки удовлетворения фундаментальных этических и правовых принципов, необходимых для создания законного автономного смертоносного оружия.” Это было бы так, если бы решения человека в сложных случаях оказались бы не алгоритмическими, как предполагает более чем одна моральная теория. Даже программы, способные учиться на обратной связи и других доказательствах, никогда не заменят принятие решений человеком, и, как выразились Кеннет Андерсон и Мэтью Ваксман, ни одна автономная система с ИИ никогда не сможет пройти “этический тест Тьюринга».”